- LajmeShqipëri Maqedoni Foleja.com Impresum Shkurt e Shqip

- Op/Ed

- Sport

Futboll Basketboll Sporte tjera- Roze

Arte Muzike Yjet TV/Film AutoTech Fun Shneta- Te tjera

Lajme

Shqipëri Maqedoni Foleja.com Impresum Shkurt e ShqipOp/Ed

Sport

Lajme

string(90) "alarmojne-ekspertet-chatbotet-mund-te-hakohen-kthehen-ne-mjet-per-aktivitete-te-paligjshme"Lajme

Gazeta Express

21/05/2025 14:05Alarmojnë ekspertët: Chatbotët mund të hakohen, kthehen në mjet për aktivitete të paligjshme

Lajme

Gazeta Express

21/05/2025 14:05Studiuesit kanë paralajmëruar se chatbot-ët e fuqizuar nga inteligjenca artificiale, që mund të jenë të hakuar, paraqesin një kërcënim serioz duke bërë të mundur qasjen e lehtë në njohuri të rrezikshme, me gjenerim të informacioneve të paligjshme që programet e thithin gjatë trajnimit.

The Guardian ka shkruar për këtë paralajmërim i cili vjen në mes të një prirjeje shqetësuese të chatbot-ëve që janë “thyer” për të anashkaluar kontrollet e sigurisë të ndërtuara brenda tyre. Kufizimet e “thyera” apo “hakuara”, janë të menduara për të parandaluar që programet të japin përgjigje të dëmshme, njëanshme ose të papërshtatshme për pyetjet e përdoruesve.

Motorët që fuqizojnë chatbot-ët si ChatGPT, Gemini dhe Claude – modele të mëdha gjuhësore (LLM) – trajnohen me sasi të mëdha materiali nga interneti.

The Guardian shkruan se, megjithë përpjekjet për të hequr tekstet e dëmshme nga të dhënat trajnuese, chatbotët ende mund të përthithin informacion mbi aktivitete të paligjshme si hakerimi, pastrimi i parave, tregtia me informacion të brendshëm dhe ndërtimi i bombave.

E në një raport të fundit mbi këtë kërcënim, studiuesit konkludojnë se është e lehtë të mashtrosh shumicën e chatbot-ëve me AI për të gjeneruar informacion të dëmshëm dhe të paligjshëm, duke treguar se rreziku është “i menjëhershëm, i prekshëm dhe thellësisht shqetësues”.

“Ajo që dikur ishte e kufizuar për aktorë shtetërorë ose grupe të krimit të organizuar, së shpejti mund të jetë në duart e kujtdo që ka një laptop apo edhe një telefon celular,” kanë thënë studiuesit.

“Jailbreaking” apo “thyerja” e chatbotëve bëhet me komanda të hartuara me kujdes për të mashtruar ata që të japin përgjigje që zakonisht janë të ndaluara. Këto komanda shfrytëzojnë tensionin mes objektivit kryesor të programit – për të ndjekur udhëzimet e përdoruesit – dhe objektivit dytësor – për të shmangur përgjigje të dëmshme, të njëanshme, joetike ose të paligjshme. Hakimet e tyre, krijojnë skenarë ku programi e vendos ndihmën për përdoruesin mbi kufizimet e sigurisë.

Të tjera nga rubrika

Duket së kreu i Hamasit Mohammed Sinwar është vrarë – thotë Benjamin Netanyahu

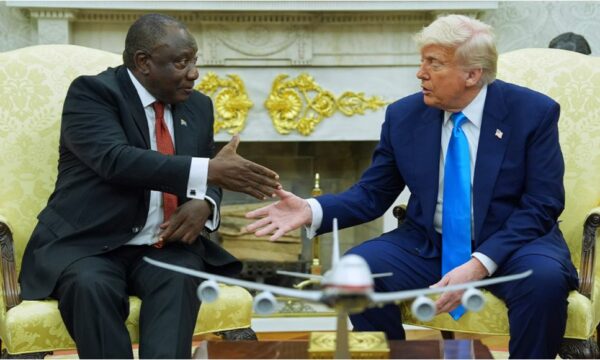

Përplasje tjetër në Shtëpinë e Bardhë, Trump flet për gjenocid ndaj të bardhëve në Afrikën e Jugut, Presidenti i këtij vendi ia kthen

Osmani në Zvicër: Mërgata jonë, nuk është thjesht pjesë e shoqërisë zvicerane, por motor i zhvillimit të saj

Pentagoni njofton se e ka pranuar aeroplanin 400 milionësh nga Katari: Trump do ta përdor pas modifikimeve

Një zyrtare policore në Ferizaj gjeti 100 euro gjatë patrullimit, ia kthen pronarit

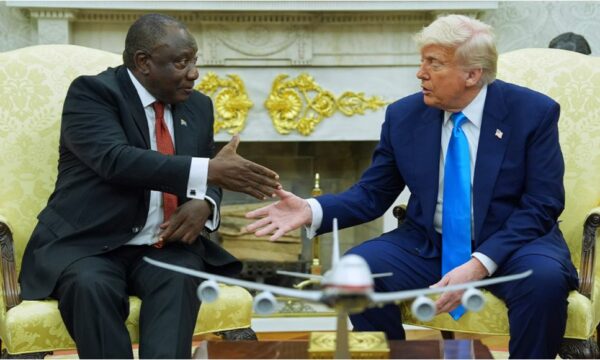

Trump takohet me presidentin e Afrikës së Jugut në Shtëpinë e Bardhë

Te fundit

Duket së kreu i Hamasit Mohammed Sinwar është vrarë – thotë Benjamin Netanyahu

Përplasje tjetër në Shtëpinë e Bardhë, Trump flet për gjenocid ndaj të bardhëve në Afrikën e Jugut, Presidenti i këtij vendi ia kthen

Osmani në Zvicër: Mërgata jonë, nuk është thjesht pjesë e shoqërisë zvicerane, por motor i zhvillimit të saj

Thaqi beson se Prishtina me Plisat e fitojnë Kupën ndaj Llapit

Pentagoni njofton se e ka pranuar aeroplanin 400 milionësh nga Katari: Trump do ta përdor pas modifikimeve

Një zyrtare policore në Ferizaj gjeti 100 euro gjatë patrullimit, ia kthen pronarit

✕

Edicioni

Edicioni

t7 live

t7 live